Bildton

Interaktives Tool zur musikalischen Interpretation von Bewegtbild

Bachelorthesis Raphael Benz

Hochschule für Gestaltung und Kunst Basel, 2020

Einleitung

Als visueller Gestalter und als Musiker interessiert mich die Schnittstelle zwischen visuellen und auditiven

Medien, weshalb ich dieses Feld in meiner Bachelorthesis zum Gegenstand der Untersuchung gemacht habe. Ich suche

nach Wegen, wie visuelle Medien genutzt werden könenn zur Generierung, Komposition und Manipulation von Musik.

Das Endresultat ist ein Tool, das Bewegtbilder in Melodien, Geräusche und Rhythmen

umwandeln kann. Es funktioniert ohne Installation im Browser, aber auch in Kombination mit externer Hard- und

Software.

Ich bedanke mich herzlich bei meinen Mentoren Prof. Marion Fink, Jinsu Ahn und Ted Davis, meinen Kommilitoninnen und Kommilitonen sowie meinen Eltern Suzanne und Marco für ihre Unterstützung bei dieser Arbeit.

Prozessdokumentation

Vorliegend zeige ich meinen gestalterischen Prozess auf, der mich zum Endresultat meiner Arbeit brachte. Der Prozess ist chronologisch aufgebaut und endet mit dem interaktiven Tool "Bildton", das meine Bachelorarbeit abschliesst.

Audiovisualisierungen

Im zweiwöchigen Workshop zu Beginn der Bachelorarbeit experimentierte ich im Bereich der Audiovisualisierung und nutzte verschiedenste Techniken, Geräte und Materialien dazu.

Visuelle Recherchen zum Thema "Audiovisualisierungen" in Form von analogen VJ-Experimenten zu bestehenden Liedern. (Hellraumprojektor, verschiedene Materialien)

Das Oszilloskop ist ein Gerät zur Messung von elektrischen Spannungen. Auch akustische Signale können damit visualisiert werden, wie in folgenden Versuchen von mir demonstriert wird. (Oszilloskop, Gitarre, digitaler Synthesizer)

In diesem früheren Projekt wurde eine Schale mit Wasser zum Schwingen gebracht, indem sie auf einem Basslautsprecher platziert wurde. Die Frequenz des Tones wurde durch die Position des Betrachters bestimmt. Das Geschehen in der Wasserschale wurde in Echtzeit auf die Wand projiziert, damit es auch aus der Distanz betrachtet werden konnte. (Rauminstallation in Zusammenarbeit mit Jana Beyerlein, Audrey Rappolt, Adrian Pirlet)

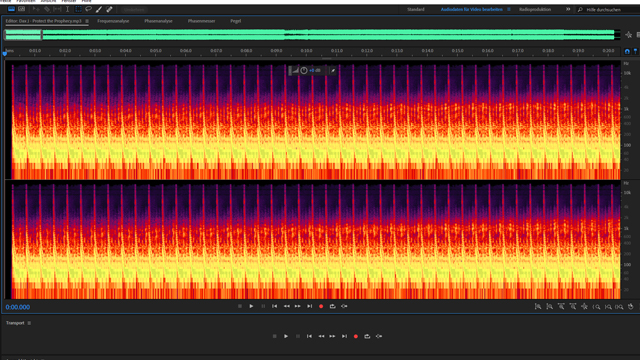

Verschiedene Arten der Frequenzanalyse von bestehenden Liedern. (Processing)

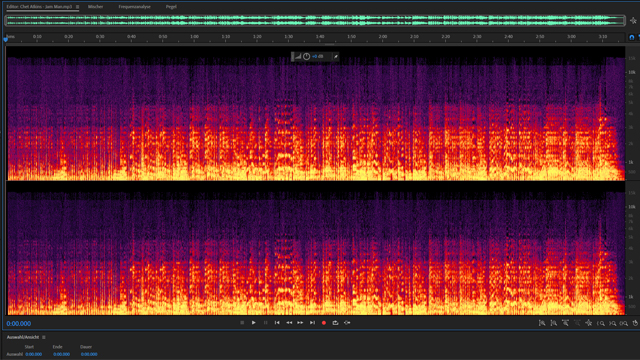

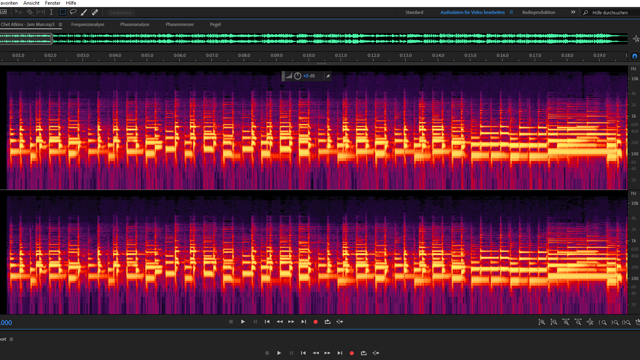

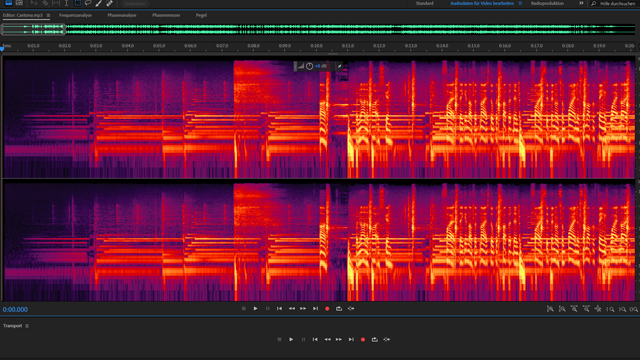

Ein Spektrogramm zeigt die Frequenzen eines Liedes (Y-Achse) im Zeitverlauf (X-Achse). Hier sind die Spektrogramme verschiedener musikalischer Genres abgebildet. (Adobe Audition)

Erste Versuche Bild-in-Ton-Übersetzung

Ich entschied mich, das Thema der Audiovisualisierungen zu verlassen und in die entgegengesetzte Richtung zu experimentieren, also Möglichkeiten der Übersetzung von Bild/Bewegtbild in Klang zu suchen. Diese Art der Intermedialität schien mir im Gegensatz zu der Audiovisualisierung noch wenig erforscht und spannend für weitere Experimente. Ich erstellte Programme in Processing und Max MSP, die visuelle Inputs in akustische Outputs verwandeln.

Interaktives Zeichentool: Mit der Maus zeichnet man auf die Leinwand. In Echtzeit wird die Helligkeit der gesamten Leinwand gemessen. Dieser Helligkeitswert steuert einen Filter an und verändert so den Klang des Rauschens. (Processing)

Videoanalyse-Tool: Je heller der Mittelpunkt des Videos, desto heller der Klang des Rauschens. (Processing)

In diesem Tool wird die Bewegung eines Videos quantifiziert, indem die Unterschiede zwischen zwei aufeinanderfolgenden Frames gemessen werden. Dieser Wert steuert die Lautstärke des Rauschens. (Max MSP)

Mögliche konzeptuelle Richtungen

Nach einigen Experimenten standen mir nun verschiedene Möglichkeiten offen, in welche Richtung sich die Arbeit konzeptuell vertiefen könnte:

- Audio-Video Installation

- Tool zur Generierung von Ton und Visuals

- Game

- Datensonifikation und -visualisierung

Audio-Video Installation mit Echtzeitübersetzung von Bild in Ton. (Als Beispiel: The Instrument vom Musikerduo Voice Crack aus dem Film "Kick that habit")

Ein Tool zur Echtzeiterzeugung und Steuerung audiovisueller Erlebnisse (Eigenes Beispiel aus Schulworkshop zur Audio- und Videosynthese, Processing).

Ein Game, das dank einfacher visuellen Interaktion spielerisch zum Musikmachen verleitet. (Beispiele: Music Insects von Toshio Iwai, Small Fish von Masaki Fujihata, Kiyoshi Furukawa, Wolfgang Münch, Manual Input Sessions von Tmema)

Visuelle und auditive Darstellung von abstrakten Daten, Datensonifikation und -visualisierung. (Beispiel: Mathematische Phänomene künstlerisch audiovisuell interpretiert von Max Cooper)

Bild-in-Klang-Übersetzung

Im Folgenden begann ich eine Untersuchung, wie man Bildaufnahmen in Klang übersetzen kann und ob sich so Aussagen machen lassen über Parallelen zwischen Bild und Klang. Dazu entwickelte ich ein Programm, das Bilder in Wellenformen umwandelt, die wiederum als akustische Wellen wiedergegeben werden.

Eigenes Tool zur Übersetzung geografischer Bilder in Klang mithile von Wavetable-Synthese

(Max

MSP).

Anmerkungen zum Video:

- Ton beginnt ab 0:27.

- 0:00 Demonstration des Tools: Das "Source Image" wird auf Kanten untersucht ("Edge Detection"). Diese Kanten sind die Grundlage der "Wavetable", welche den Klang erzeugt.

- 1:05 Beispiele mit geometrischen Formen, die einen "reinen" Klang generieren.

- 1:20 Verschiedene Beispiele mit Bilddaten von Google Maps.

Eigenes Bildmaterial zum Thema "Repetition" wird in Klang übersetzt.

Weiterentwicklung der Echtzeitübersetzung von Kamerainput oder Videos in Klang mit Wavetable-Synthesis (Processing, eigene Aufnahmen, Film: Rhythmus 21, Hans Richter 1921).

Konzept Live-Performance Tool

Es manifestierte sich die Idee, ein Live-Performance-Tool zu programmieren, das in Echtzeit Bilddaten in Musik, Bild und Bewegung übersetzt. Die Grundidee ist, dass visuelle Daten in für digitale Anwendungen lesbare Daten umgewandelt werden. Das Tool kann genutzt werden als elektronisches Musikinstrument, zur Generierung von Visuals als auch zur Steuerung motorischer Skulpturen. Das Tool so audiovisuellen Performern und Künstlern eine Möglichkeit bieten, die direkte Erfahrung der Umgebung in die Arbeit einfliessen zu lassen und damit zu improvisieren.

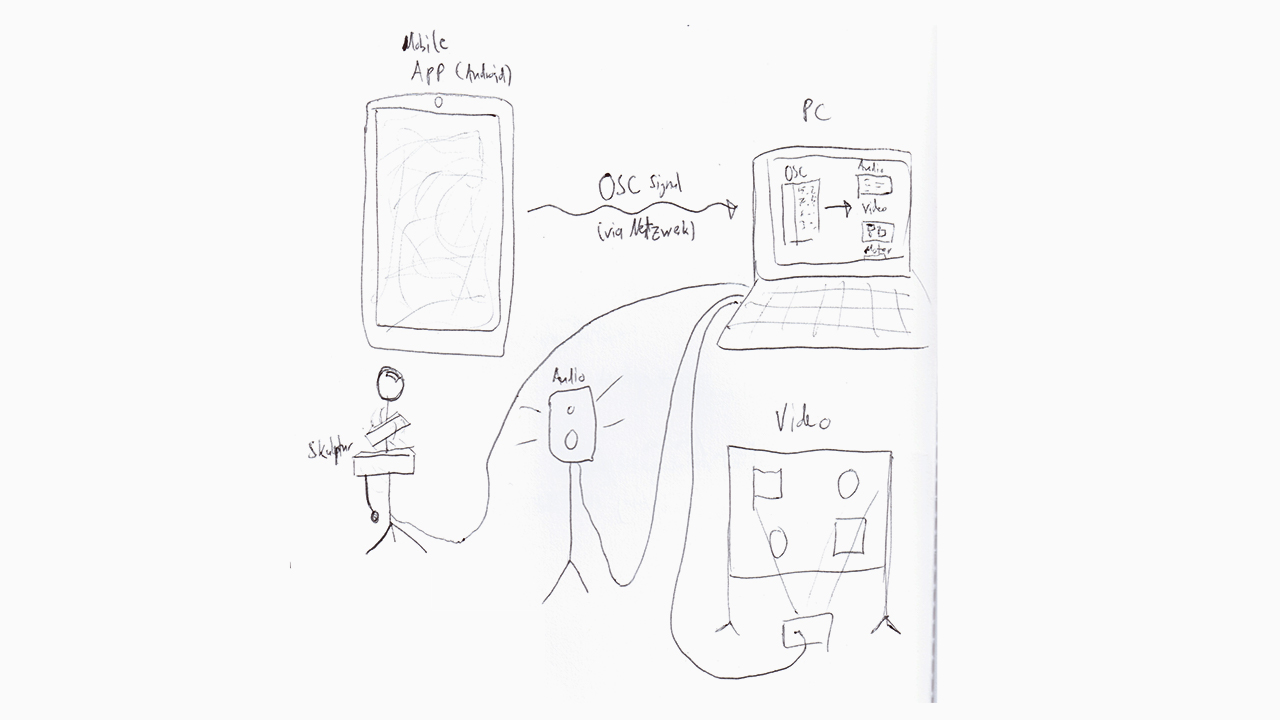

Funktionsweise der Anwendung: Die App läuft auf dem Handy oder Laptop und liest Kameradaten. Die stark abstrahierten Daten, also beispielsweise der primäre Farbwert des Kamerabildes, werden in Open Sound Control (OSC) Signale umgewandelt, die dann via Internet an eine Schnittstelle (z.B. PC) geschickt werden. Die Daten können von den meisten gängigen Musik- und Videosynthese-Programmen erkannt werden, wo sie die Musik und Visuals erzeugen und manipulieren.

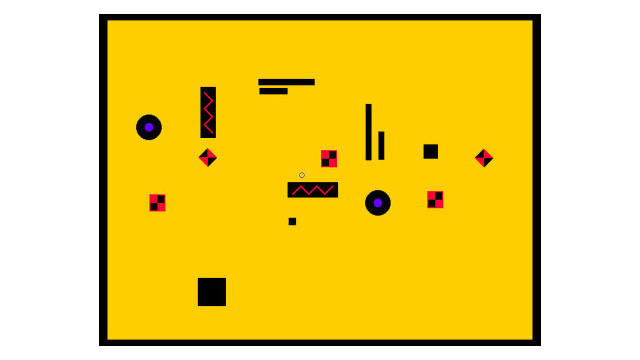

Diese Videos zeigen einen ersten Protoytpen der beschriebenen Idee. Die horizontale Mitte eines Quellvideos (o.l.) wird in regelmässigen Abständen gemessen. Punkte ab einem bestimmten Helligkeits-Schwellenwert werden an das Musikprogramm (u.l.) gesendet und dort in Noten übersetzt. Die Y-Position der Punkte bestimmt dabei die Tonhöhe. Zudem werden die Werte in ein Programm zur Videoerzeugung (u.r.) geschickt, wo sie geometrisch-abstrakt umgesetzt werden. (Processing für Videoanalyse, Max MSP für Sound, Touchdesigner für Videogenerierung)

Konzept Bewegtbild zu Musik

Das finale Konzept meiner gestalterischen Bachelorthesis ist ein Tool, das Bewegtbild in musikalische

Kompositionen umwandeln kann. Dabei nimmt es verschiedene Aspekte des Bewegtbildes wie Helligkeiten, Farben,

Bewegung und Konturen auf, quantifiziert diese Daten und wandelt sie in Melodien, Rhyhthmen und Geräusche um.

Grundstock an Videoaufnahmen mit statischer Kamera und bewegten Elementen. (Eigene Aufnahmen)

Erster interaktiver Prototyp des Programmes. Auf der linken Seite können Video- und Audioeinstellungen vorgenommen werden, rechts könenn je nach ausgewähltem Modus Parameter der Bildanalyse eingestellt werden.

Verschiedene UI Entwürfe. Die Steuerungselemente sollten nicht das Bild abdecken, aber auch einfach zu erreichen sein. (Adobe XD)

Tool "Bildton"

Unter folgendem Link kann das Tool genutzt werden:

bildton.ch

Demo Video

Das Tool funktioniert online und ohne Installation, der Quellcode ist frei verfügbar. Es kann auch in Kombination mit MIDI-kompatibler Soft- und Hardware genutzt werden. Ich habe für die Implementierung verschiedene Libraries benutzt, in erster Linie P5.js zur Bildanalyse und für die Interaktion sowie Tone.js zur Generierung der Musik. Weitere Informationen und eine genauere Anleitung befinden sich auf der Github-Seite, zusammen mit dem Sourcecode.

Anhang

Kontakt

Portfolio: 0764163012.ch

Instagram: @rbvonrb

E-Mail: r.benz@live.com

Impressum

Raphael Benz, Basel

Bachelorthesis, FS 2020

Institut Visuelle Kommunikation

FHNW HGK Basel

Mentoren: Prof. Marion Fink, Jinsu Ahn, Ted Davis

Schrift: Neue Haas Grotesk Display & Text

© Copyright 2020 by FHNW HGK /

Raphael Benz

Alle Rechte vorbehalten –

die Bildrechte liegen bei den Urhebern.